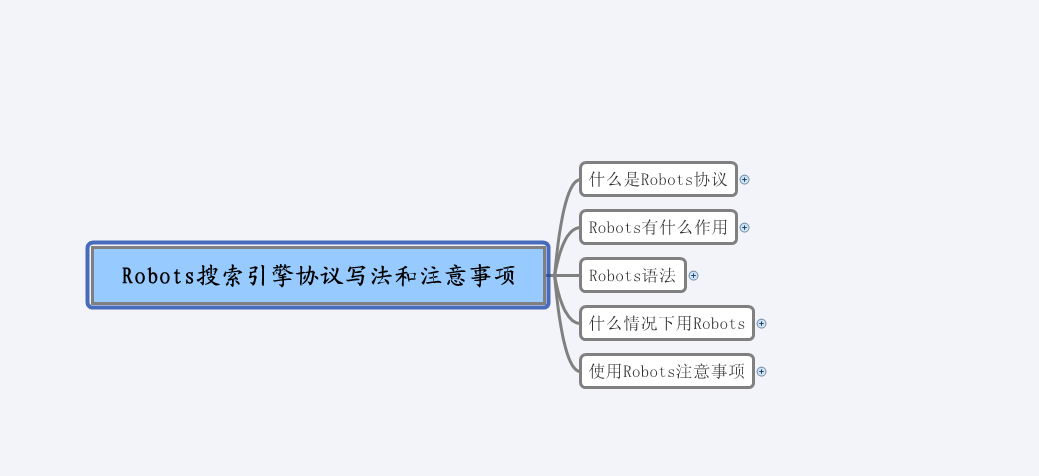

Robots.txt是什么意思?搜索引擎协议robots.txt语法大全

时间:2022-03-15 21:38编辑:九州下载来源:www.wzjsgs.com

Robots.txt是放一些网站上不想让搜索引擎抓取收录的文件,需要我们自己知道网站哪些文件是不想被收录的,比如一般网站的后台就没有必要收录以及会员信息页面等。营销建站公司通过以下五点来和大家分享是的Robots搜索引擎协议写法和注意事项。

什么是Robots协议

1>网站和搜索引擎的协议文件

2>蜘蛛爬行网站的第一个要访问的文件

Robots有什么作用

1>屏蔽网站内的死链接。

3>屏蔽搜索引擎蜘蛛抓取站点内重复内容和页面。

3>阻止搜索引擎索引网站隐私性的内容

Robots语法

1>User-agent定义搜索引擎类型:

(1)百度蜘蛛:Baiduspider

(2)谷歌蜘蛛:Googelebot

(3)360蜘蛛:360Spider

(4)Soso蜘蛛:Sosospider

(5)有道蜘蛛:YoudaoBot

(6)搜狗蜘蛛:SohpiNews Spider 等

2>Disallow禁止抓取收录地址:

(1)禁止整站:写法 User-agent: Baiduspider Disallow: /

(2)禁止一个文件夹:写法 User-agent: Baiduspider Disallow: /data

(3)禁止文件:写法 User-agent: Baiduspider Disallow: /jianzhan/list_1.html

(4)禁止动态路径: 本来是动态路径,后面又修改成静态路径,导致两个不同路径同时能访问一个页面,我们可以把动态路径禁止,动态链接的一个标准符号就是“?”因此禁抓动态Url命令写作:Disallow: /*?*

3>Allow定义抓取收录地址:写法 Allow: /data/common.inc.php

4>语法符合:

(1)/单个符合搜索引擎认为是根目录:写法:Disallow: /*.php$

(2)*能匹配0或者所有英文字符:自由主题

(3)$结束符

什么情况下用Robots

1>统一路径,动态和静态 www.wglseo.com/

2>搜索链接

3>标签链接

4>中文链接

5>根据情况,不想让网站收录的文件,隐私文件,会员注册等

使用Robots注意事项

1>符合使用的细节[/ : 空格 大小写]

2>生效时间[几天或者两个月以内]

3>不要随便屏蔽整站

相关文章

-

怎么快速渡过新站考核期?

好多的朋友应该都知道百度有新站的考核期,但是可能对考核期具体是什么,以及怎么快速的渡过新站百度的考核期,还是会有一些疑惑,那今天小编就带大家了解一下考核期,以及渡过考核期的方法.

2023-03-18 11:12 -

HITS算法对于优化的影响

HITS算法并不是百度独家的, 它被应用在很多的地方,关于它太低层的术语的东西这里不预深究,这里之讲它对优化的影响,首先HITS把页面分为了两种

2023-03-18 11:09 -

原创文章为什么没有排名?

为什么原创内容没有排名,这个问题有点不严谨,这几天有个朋友和我说他的原创文章发了一个月了百度也会收录,但是就没有排名想让我给分析一下,我打开内容一看,直呼好家伙

2023-03-18 11:04 -

怎么写出用户喜欢的文章?

做网站优化很重要的一点是写出用户喜欢的内容,请注意是用户喜欢,不是百度喜欢的,百度喜欢的内容是灰帽写的那种文章,带点ascii码中百度识别不了的字符,这种会有好的收录跟排名,但我们是白帽,我们是面向用户做优化,不是面向快排,面向爬虫做快排,用户喜欢的文章,不一定是原创,如果不懂文章要不要原创的可以看一下之前在\'SEO网站优化文章一定要原创吗\'中的内容。

2023-03-18 11:01 -

网站运营岗位职责

大家对网站运营可能都听过,也经常听别人讲起,网站运营可以算做是运营的细分,运营跟网站运营的工作内容区别是很大的,之前有面试运营岗位的同志,来了以后一聊工作内容,说跟他理解的运营工作内容不一样,你看这对岗位职责理解不太明确,导致白跑了一趟!

2023-03-18 10:58 -

网络营销与SEO有什么关系

有些刚接触SEO的朋友经常能看见有些网站是做优化的,但是还会同时做网络营销这个业务,那网络营销和SEO有什么关系那?

2023-03-18 10:58